目标并竭力推动您的项目效益提升

高功耗、高密度是数据中心的未来,液冷将成AI服务器散热主流方案。

随着大模型等系列 AIGC 产品的商业化落地,AI 服务器的需求将会快速提升,其中大量的高功率 CPU、GPU 芯片将带动整台 AI 服务器功耗走高。CPU 方面,随着内核数量的增加,处理器性能不断提高,带动处理器功率不断增加,特殊场景下(如高性能云计算)处理器将使用超频以提高运算性能,进一步提升功耗。GPU 方面,最新的一些产品最高功耗可达 700W,已超出传统风冷系统散热的能力范畴。

未来 AI 集群算力密度普遍有望达到 20-50kW/柜,自然风冷技术一般只支持 8-10kW,冷热风道隔离的微模块加水冷空调水平制冷在机柜功率超过 15kW 后性价比大幅下降,液冷散热方案的能力与经济性优势逐步凸显。

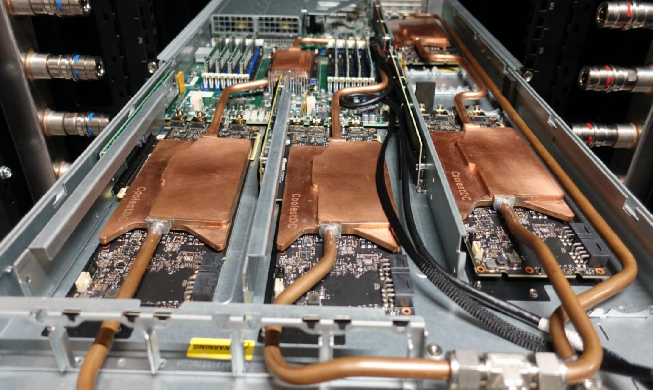

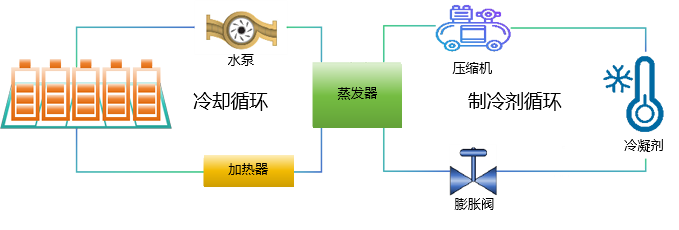

冷却液在泵的驱动下通过管路循环。当冷却剂流经服务器内部的热交换器时,它与高温组件(如CPU、GPU等)进行热交换,带走热量。

冷却剂通过散热器将热量散发到环境中,保持低温状态,从而实现服务器的连续稳定运行。